Kleine KI-Modelle im Fokus: Effizienz und Anwendungsmöglichkeiten in der Zukunft

KI sauber im Unternehmen integrieren: Der 5-Schritte-Plan

Von der ersten Idee bis zur voll integrierten KI-Lösung – strukturiert, sicher und mit messbarem Erfolg

Strategie & Zieldefinition

Wir analysieren Ihre Geschäftsprozesse und identifizieren konkrete Use Cases mit dem höchsten ROI-Potenzial.

✓ Messbare KPIs definiert

Daten & DSGVO-Compliance

Vollständige Datenschutz-Analyse und Implementierung sicherer Datenverarbeitungsprozesse nach EU-Standards.

✓ 100% DSGVO-konform

Technologie- & Tool-Auswahl

Maßgeschneiderte Auswahl der optimalen KI-Lösung – von Azure OpenAI bis zu Open-Source-Alternativen.

✓ Beste Lösung für Ihren Fall

Pilotprojekt & Integration

Schneller Proof of Concept mit nahtloser Integration in Ihre bestehende IT-Infrastruktur und Workflows.

✓ Ergebnisse in 4-6 Wochen

Skalierung & Team-Schulung

Unternehmensweiter Rollout mit umfassenden Schulungen für maximale Akzeptanz und Produktivität.

✓ Ihr Team wird KI-fit

Inhaltsverzeichnis

Optimieren Sie Prozesse, automatisieren Sie Workflows und fördern Sie Zusammenarbeit – alles an einem Ort.

Das Wichtigste in Kürze

- Kleine Modelle für KI-Anwendungen gewinnen an Bedeutung, insbesondere im Bereich von Edge-Geräten und lokalen Inferenzen.

- Die Effizienz und geringe Kosten kleiner Modelle ermöglichen neue Anwendungsfälle, beispielsweise in der Robotik und in spezialisierten Coding-Agenten.

- Obwohl größere Modelle oft als leistungsfähiger gelten, zeigen kleinere, spezialisierte Modelle in bestimmten Bereichen beeindruckende Ergebnisse, teils vergleichbar mit oder überlegen gegenüber ihren größeren Pendants.

- Die Entwicklung von optimierten Frameworks und Quantisierungstechniken ist entscheidend, um die Leistung kleiner Modelle auf heterogener Hardware zu maximieren.

- Diskussionen über "Tiny Models" im Kontext von "Big Orbit" unterstreichen das Potenzial für dezentrale und spezialisierte KI-Lösungen, die auch in ressourcenbeschränkten Umgebungen eingesetzt werden können.

Der Trend zu "Tiny Models" in der KI-Landschaft: Große Wirkung in kleinen Dimensionen

Die Diskussion um "Tiny Models" und ihre Fähigkeit, "große Orbits" zu erreichen, gewinnt in der Welt der künstlichen Intelligenz zunehmend an Bedeutung. Dieser Trend, der im Wesentlichen die Entwicklung und den Einsatz kleinerer, effizienterer KI-Modelle beschreibt, verspricht, die Anwendbarkeit von KI auf eine breitere Palette von Geräten und in ressourcenbeschränkten Umgebungen zu erweitern. Als Senior Specialist Journalist und Analyst für Mindverse beleuchten wir die Implikationen dieser Entwicklung für B2B-Anwendungen und die zukünftige Ausrichtung der KI-Technologie.

Die Renaissance der Effizienz: Warum kleine Modelle immer größer werden

In den Anfangsjahren der modernen KI-Entwicklung lag der Fokus oft auf der Skalierung von Modellen. Die Annahme war, dass größere Modelle mit mehr Parametern und Daten unweigerlich zu besserer Leistung führen würden. Dies hat zur Entwicklung von Giganten wie GPT-3 und anderen Large Language Models (LLMs) geführt. Doch parallel dazu hat sich ein Gegentrend etabliert, der die Leistungsfähigkeit und Effizienz kleinerer Modelle in den Vorder Vordergrund rückt.

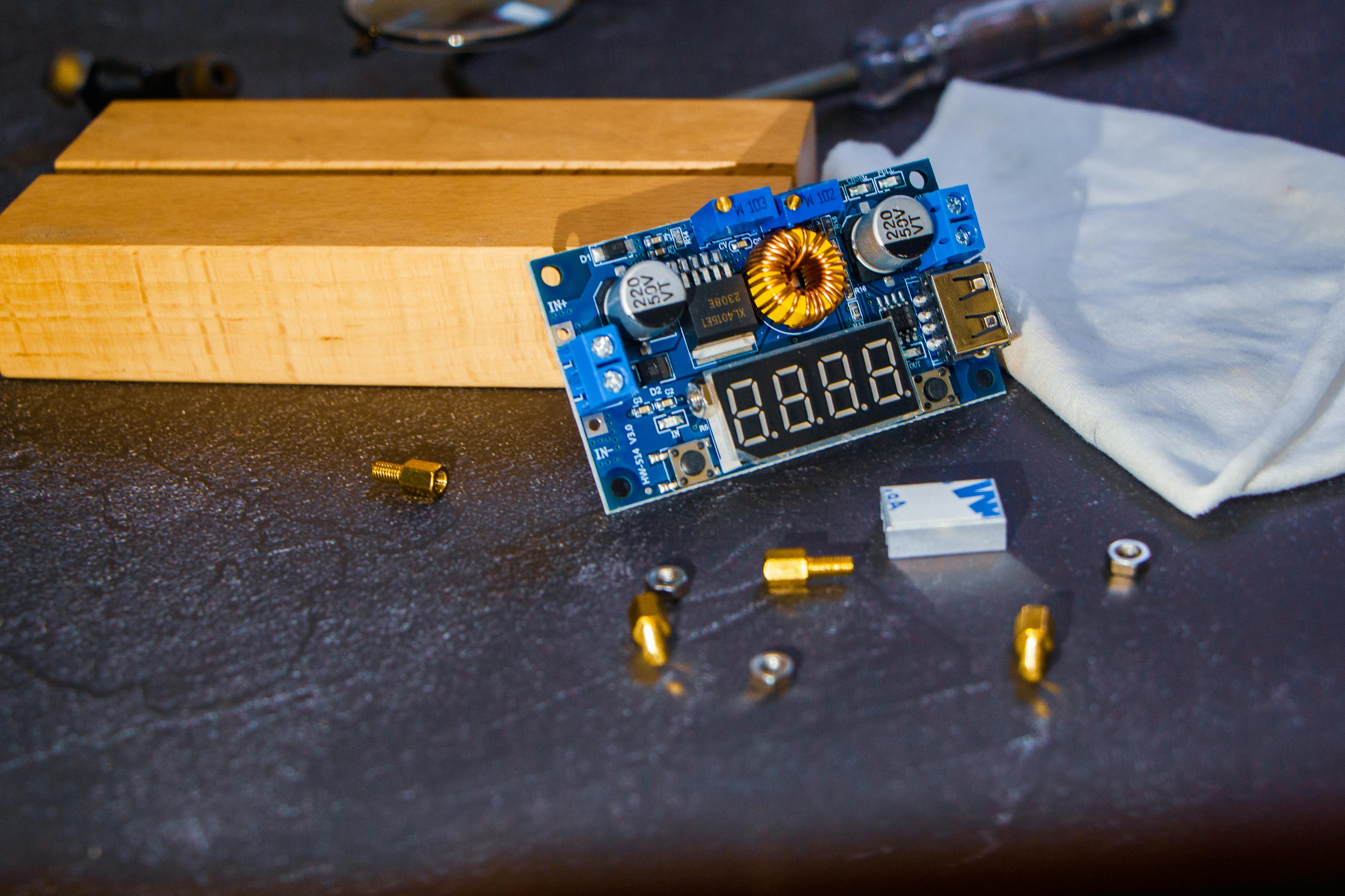

Ein "Tiny Model" ist dabei nicht unbedingt nur ein kleineres LLM. Der Begriff umfasst eine breite Palette von Modellen, die darauf ausgelegt sind, mit weniger Rechenleistung, Speicher und Energie auszukommen. Dies ist besonders relevant für Anwendungen auf Edge-Geräten, in eingebetteten Systemen oder in Szenarien, in denen eine schnelle, lokale Inferenz ohne Cloud-Anbindung erforderlich ist.

Anwendungsfelder und Potenziale von Tiny Models

Die Anwendungsmöglichkeiten von Tiny Models sind vielfältig und erstrecken sich über verschiedene Branchen:

- Edge AI und IoT: In Smart-Home-Geräten, Wearables oder industriellen Sensoren ermöglichen Tiny Models die lokale Verarbeitung von Daten, was zu geringerer Latenz, verbessertem Datenschutz und reduziertem Bandbreitenverbrauch führt.

- Robotik: Für autonome Roboter, die in Echtzeit auf ihre Umgebung reagieren müssen, sind schnelle und effiziente Inferenzzeiten entscheidend. Tiny Models können hierbei die Entscheidungsfindung direkt auf dem Gerät beschleunigen, wie beispielsweise im Bereich der geschickten Robotik gezeigt wird, wo Modelle auf riesigen Datenmengen trainiert werden, um physikalisches "Common Sense" zu entwickeln.

- Spezialisierte Coding-Agenten: Im Bereich der Softwareentwicklung können kleine, spezialisierte Modelle für Aufgaben wie Code-Vervollständigung, Fehlererkennung oder sogar die Generierung kleiner Code-Snippets eingesetzt werden, ohne auf ressourcenintensive Cloud-LLMs angewiesen zu sein.

- Medizinische Diagnostik: In der medizinischen Bildgebung oder bei der Analyse von Biosignalen können Tiny Models eine schnelle Voranalyse oder Filterung direkt auf mobilen oder spezialisierten Geräten ermöglichen.

Ein Beispiel für die Effizienz kleinerer Modelle liefert der Erfolg von Qwen-Modellen, die in bestimmten Benchmarks mit deutlich größeren US-amerikanischen Modellen konkurrieren oder diese sogar übertreffen. Dies deutet darauf hin, dass die reine Größe nicht immer der entscheidende Faktor für die Leistungsfähigkeit ist, sondern vielmehr die Architektur, die Trainingsdaten und die Optimierung für spezifische Aufgaben.

Technologische Wegbereiter: Quantisierung und effiziente Frameworks

Die Realisierung von Tiny Models wäre ohne signifikante Fortschritte in der Modelloptimierung kaum denkbar. Schlüsseltechnologien in diesem Bereich umfassen:

- Quantisierung: Hierbei wird die Präzision der Modellgewichte reduziert (z.B. von 32-Bit-Floating-Point auf 8-Bit-Integer oder sogar 2-Bit-Quantisierung), wodurch der Speicherbedarf und die Rechenlast drastisch sinken, oft mit nur geringem Leistungsverlust. Frameworks wie

llama.cppnutzen diese Techniken, um große Sprachmodelle (LLMs) auf Consumer-Hardware lauffähig zu machen. - Destillation: Bei der Knowledge Distillation wird das Wissen eines großen "Lehrer"-Modells auf ein kleineres "Schüler"-Modell übertragen, wodurch das kleinere Modell ähnliche Leistungen wie das größere erzielen kann.

- Spezialisierte Architekturen: Die Entwicklung von Architekturen, die von Grund auf für Effizienz konzipiert sind, wie beispielsweise die Verwendung von Mixture-of-Experts (MoE) Modellen mit wenigen aktiven Parametern, trägt ebenfalls zur Leistungssteigerung bei geringem Ressourcenverbrauch bei.

- Optimierte Frameworks: Werkzeuge wie MLX von Apple oder vLLM für das Serving von LLMs sind entscheidend, um die Leistung von Modellen auf spezifischer Hardware zu maximieren und Engpässe zu vermeiden.

Die Diskussion um "Tiny Models, Big Orbit"

Die Metapher des "Tiny Models, Big Orbit" verdeutlicht, dass selbst kleine KI-Modelle das Potenzial haben, weitreichende Auswirkungen zu erzielen. Dies geschieht nicht nur durch ihre breite Verfügbarkeit und Anpassungsfähigkeit, sondern auch durch ihre Fähigkeit, in Nischenanwendungen oder auf dezentralen Systemen eine signifikante Rolle zu spielen.

Ein faszinierendes Beispiel für die Ausweitung des "Orbits" ist der Vorschlag von Google, skalierbare ML-Rechensysteme im Orbit zu prototypisieren, um die reichlich vorhandene Sonnenenergie zu nutzen. Obwohl dies derzeit noch in den Kinderschuhen steckt, zeigt es die Kreativität und den Weitblick, mit denen die KI-Community die Grenzen des Möglichen auslotet.

Die Debatte über die "Tiny Models" ist jedoch nicht ohne Herausforderungen. Die Vergleichbarkeit von Benchmarks über verschiedene Hardware-Architekturen und Quantisierungsgrade hinweg ist komplex. Zudem müssen weiterhin Wege gefunden werden, um die Transparenz und Interpretierbarkeit kleinerer, hochoptimierter Modelle zu gewährleisten, insbesondere in kritischen Anwendungen.

Ausblick für Unternehmen

Für B2B-Kunden bedeutet der Trend zu Tiny Models eine Verschiebung hin zu flexibleren, kostengünstigeren und datenschutzfreundlicheren KI-Lösungen. Anstatt sich ausschließlich auf große, allgemeine Modelle zu verlassen, können Unternehmen gezielt spezialisierte, effiziente Modelle einsetzen, die exakt auf ihre Bedürfnisse zugeschnitten sind. Dies eröffnet neue Möglichkeiten für Innovationen in der Produktentwicklung, der Prozessoptimierung und der Schaffung neuer Geschäftsmodelle.

Die Fähigkeit, KI direkt auf Geräten oder in lokalen Umgebungen zu betreiben, reduziert die Abhängigkeit von externen Cloud-Diensten und minimiert potenzielle Datenschutzrisiken. Gleichzeitig wird der Zugang zu fortschrittlicher KI-Technologie demokratisiert, da auch kleinere Unternehmen oder Start-ups mit begrenzten Ressourcen leistungsstarke KI-Anwendungen entwickeln und implementieren können.

Zusammenfassend lässt sich sagen, dass die "Tiny Models" kein vorübergehender Trend sind, sondern eine fundamentale Entwicklung, die die Zukunft der künstlichen Intelligenz maßgeblich prägen wird. Ihre Effizienz, Anpassungsfähigkeit und das Potenzial, in diversen Umgebungen einen großen Einfluss auszuüben, machen sie zu einem entscheidenden Faktor für Unternehmen, die im Zeitalter der KI wettbewerbsfähig bleiben wollen.

Bibliographie

- AINews - smol.ai. (2025, 4. November). not much happened today. Abgerufen von https://news.smol.ai/issues/25-11-04-not-much/

- AINews - Smol AI News. (2025, 14. November). not much happened today. Abgerufen von https://news.smol.ai/issues/25-11-14-not-much/

- Buttondown. (2024, 12. März). [AINews] The world's first fully autonomous AI Engineer. Abgerufen von https://buttondown.com/ainews/archive/ainews-the-worlds-first-fully-autonomous-ai/

- Buttondown. (2025, 28. März). [AINews] not much happened today. Abgerufen von https://buttondown.com/ainews/archive/ainews-not-much-happened-today-3156/

- cafiac.com. Yan Le Cun. Abgerufen von https://cafiac.com/?q=fr/IAExpert/yan-le-cun

- Crockett, C. (2019, 8. August). Tiny moon orbits dwarf planet. Science News. Abgerufen von https://www.sciencenews.org/article/tiny-moon-orbits-dwarf-planet

- Naidu, S., & Farnocchia, D. (2020, 27. Februar). Tiny Object Discovered in Distant Orbit Around the Earth. CNEOS. Abgerufen von https://cneos.jpl.nasa.gov/news/news205.html

- sergeykarayev.com. (2026, 3. Januar). X/Twitter Archive for @sergeykarayev. Abgerufen von https://sergeykarayev.com/x-backup/index.html

- Techmeme. (2023, 11. Mai). Anthropic expands Claude's context window from 9K to 100K tokens ... Abgerufen von https://www.techmeme.com/230511/p35

- The Coli. (2022, 22. Dezember). Large Language Models News & Discussions | Page 141. Abgerufen von https://www.thecoli.com/threads/large-language-models-news-discussions.952923/post-55625353

.svg)

.png)