Fortschritte und Herausforderungen bei der Videogenerierung als Weltmodelle

KI sauber im Unternehmen integrieren: Der 5-Schritte-Plan

Von der ersten Idee bis zur voll integrierten KI-Lösung – strukturiert, sicher und mit messbarem Erfolg

Strategie & Zieldefinition

Wir analysieren Ihre Geschäftsprozesse und identifizieren konkrete Use Cases mit dem höchsten ROI-Potenzial.

✓ Messbare KPIs definiert

Daten & DSGVO-Compliance

Vollständige Datenschutz-Analyse und Implementierung sicherer Datenverarbeitungsprozesse nach EU-Standards.

✓ 100% DSGVO-konform

Technologie- & Tool-Auswahl

Maßgeschneiderte Auswahl der optimalen KI-Lösung – von Azure OpenAI bis zu Open-Source-Alternativen.

✓ Beste Lösung für Ihren Fall

Pilotprojekt & Integration

Schneller Proof of Concept mit nahtloser Integration in Ihre bestehende IT-Infrastruktur und Workflows.

✓ Ergebnisse in 4-6 Wochen

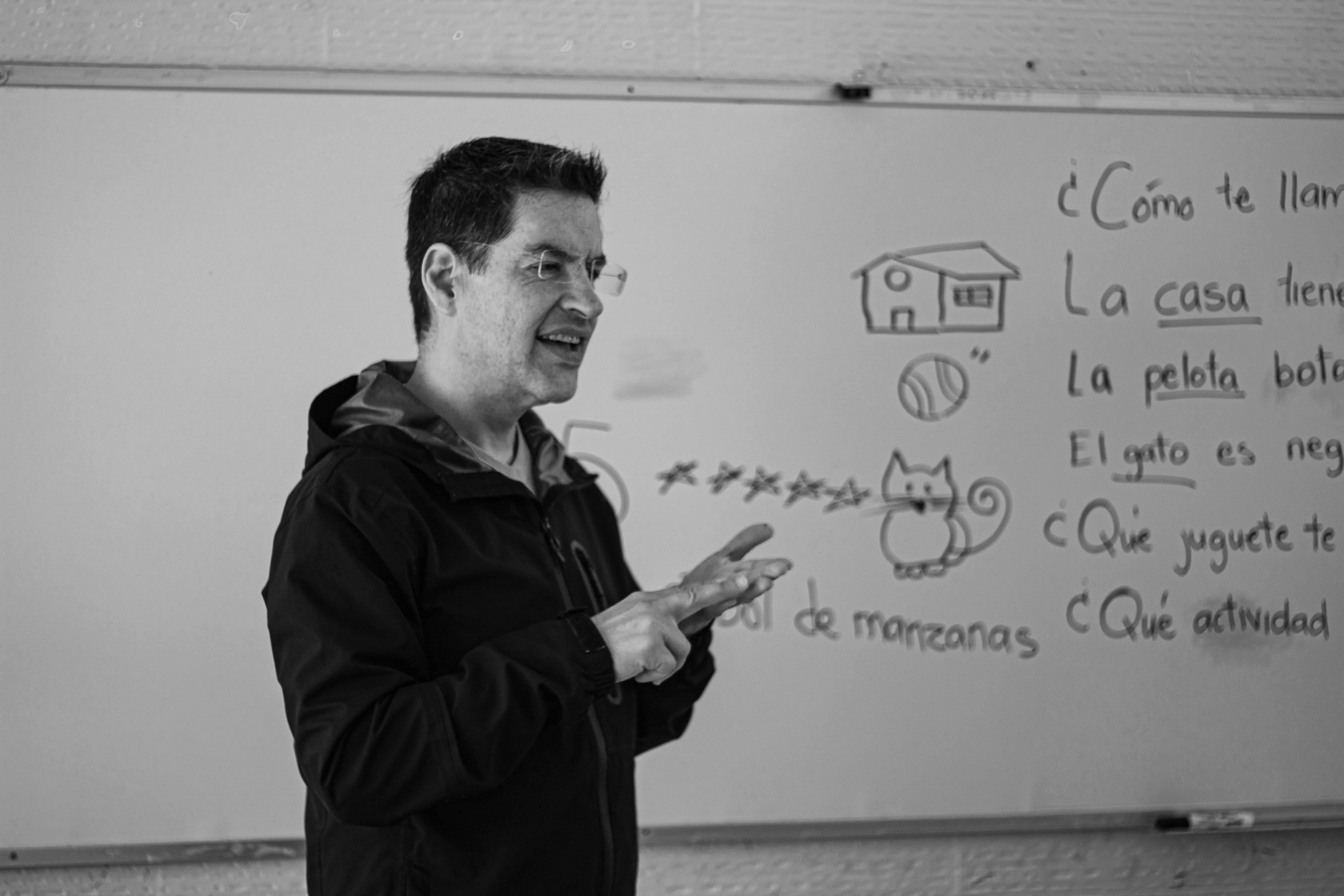

Skalierung & Team-Schulung

Unternehmensweiter Rollout mit umfassenden Schulungen für maximale Akzeptanz und Produktivität.

✓ Ihr Team wird KI-fit

Inhaltsverzeichnis

Optimieren Sie Prozesse, automatisieren Sie Workflows und fördern Sie Zusammenarbeit – alles an einem Ort.

Das Wichtigste in Kürze

- Große Videogenerierungsmodelle zeigen Ansätze physikalischer Kohärenz, sind jedoch noch keine vollwertigen Weltmodelle.

- Eine neue Taxonomie unterteilt Videogenerierungsmodelle in Zustandsbildung und Dynamikmodellierung.

- Die Zustandsbildung erfolgt implizit (Kontextmanagement) oder explizit (latente Kompression).

- Die Dynamikmodellierung wird durch Wissensintegration und architektonische Reformulierung analysiert.

- Die Bewertung sollte sich von visueller Qualität hin zu funktionalen Benchmarks wie physikalischer Persistenz und kausalem Denken verschieben.

- Kritische Herausforderungen sind die Verbesserung der Persistenz durch datengesteuerte Speicher und die Förderung der Kausalität durch Entkopplung latenter Faktoren.

- Das Modell PAN ist ein Beispiel für ein interaktives Weltmodell, das in der Lage ist, zukünftige Weltzustände anhand von Aktionen und natürlicher Sprache zu simulieren.

Die Forschung im Bereich der Künstlichen Intelligenz (KI) hat in den letzten Jahren erhebliche Fortschritte bei der Videogenerierung erzielt. Große Modelle sind heute in der Lage, visuell plausible Videos zu erzeugen, die oft eine überraschende physikalische Kohärenz aufweisen. Diese Entwicklung wirft die Frage auf, inwieweit solche Modelle als sogenannte "Weltmodelle" fungieren können – also als Systeme, die nicht nur visuelle Daten generieren, sondern auch die zugrunde liegenden physikalischen Gesetze und kausalen Zusammenhänge einer simulierten Welt verstehen und vorhersagen können. Eine aktuelle Studie beleuchtet diese Fragestellung detailliert und schlägt eine mechanistische Sichtweise auf Videogenerierung als Weltmodelle vor.

Videogenerierung als Weltmodelle: Eine Mechanistische Perspektive

Die Untersuchung "A Mechanistic View on Video Generation as World Models: State and Dynamics" analysiert die Kluft zwischen modernen "zustandslosen" Videoarchitekturen und den "zustandszentrierten" Theorien klassischer Weltmodelle. Der Kerngedanke der Arbeit ist die Einführung einer neuen Taxonomie, die auf zwei Hauptpfeilern basiert: der Zustandsbildung (State Construction) und der Dynamikmodellierung (Dynamics Modeling).

Zustandsbildung: Implizit vs. Explizit

Die Zustandsbildung in Videogenerierungsmodellen kann auf unterschiedliche Weisen erfolgen:

- Implizite Paradigmen (Kontextmanagement): Hierbei wird der Zustand der Welt indirekt durch das Management des visuellen Kontexts über mehrere Frames hinweg erfasst. Das Modell lernt aus den aufeinanderfolgenden Bildern, wie sich Objekte und Szenen entwickeln, ohne explizit einen internen Zustand zu repräsentieren.

- Explizite Paradigmen (latente Kompression): Bei diesem Ansatz wird ein expliziter, komprimierter latenter Zustand der Welt konstruiert. Dieser latente Raum soll die wesentlichen Informationen über die Szene, die Objekte und deren Eigenschaften enthalten, die für die Vorhersage zukünftiger Frames notwendig sind.

Dynamikmodellierung: Wissensintegration und Architektonische Reformulierung

Die Dynamikmodellierung befasst sich damit, wie Videogenerierungsmodelle die zeitliche Entwicklung einer Szene erfassen und vorhersagen. Hierbei werden zwei Hauptansätze unterschieden:

- Wissensintegration: Dieser Ansatz integriert explizites oder implizites Wissen über physikalische Gesetze oder kausale Zusammenhänge in das Modell. Dies kann beispielsweise durch die Verwendung von Trainingsdaten geschehen, die physikalische Prinzipien deutlich widerspiegeln, oder durch architektonische Elemente, die solche Prinzipien bevorzugen.

- Architektonische Reformulierung: Hierbei werden die Modellarchitekturen so angepasst, dass sie die Modellierung von Dynamiken besser unterstützen. Dies kann die Einführung von rekurrenten Elementen, Aufmerksamkeitsmechanismen oder ganz neuen Modellstrukturen umfassen, die darauf ausgelegt sind, zeitliche Abhängigkeiten effektiver zu verarbeiten.

Herausforderungen und zukünftige Forschungsrichtungen

Die Autoren der Studie identifizieren zwei zentrale Herausforderungen, die für die Weiterentwicklung von Videogenerierungsmodellen zu robusten, universellen Weltsimulatoren entscheidend sind:

- Verbesserung der Persistenz: Aktuelle Modelle haben Schwierigkeiten, die physikalische Persistenz von Objekten über längere Zeiträume hinweg aufrechtzuerhalten. Dies äußert sich oft in inkonsistenten Objektidentitäten oder unerwartetem Verhalten. Eine Lösung wird in datengesteuerten Speicher- und komprimierten Wiedergabetreue-Mechanismen gesehen.

- Förderung der Kausalität: Die Fähigkeit, kausale Zusammenhänge zu verstehen und zu nutzen, ist für echte Weltmodelle unerlässlich. Dies erfordert eine Entkopplung latenter Faktoren und die Integration von Reasoning-Prioritäten in die Modelle.

Die Kluft zwischen visueller Qualität und physikalischem Verständnis

Ein wesentlicher Punkt der Studie ist die Notwendigkeit, den Fokus der Evaluierung von Videogenerierungsmodellen zu verschieben. Bisher lag der Schwerpunkt oft auf der visuellen Qualität und Plausibilität der generierten Videos. Für die Entwicklung echter Weltmodelle ist es jedoch entscheidend, funktionale Benchmarks zu verwenden, die die physikalische Persistenz und das kausale Denken testen. Ein Modell, das visuell ansprechende Videos produziert, aber physikalische Gesetze verletzt oder inkonsistente Kausalitäten aufweist, ist kein echtes Weltmodell.

Das PAN-Modell: Ein Schritt in Richtung umfassender Weltsimulation

Im Kontext dieser Diskussion ist das PAN-Modell (Predictive Action Network) ein Beispiel für einen vielversprechenden Forschungsansatz. PAN ist ein Weltmodell, das in der Lage ist, zukünftige Weltzustände durch qualitativ hochwertige Videosimulationen zu prognostizieren, die durch die Historie und Aktionen in natürlicher Sprache bedingt sind. Es integriert eine autoregressive latente Dynamik auf Basis eines großen Sprachmodells (LLM) mit einem Videodiffusions-Decoder, um eine Vereinigung von latentem Raum-Reasoning und realisierbaren Welt-Dynamiken zu erreichen.

PAN wurde auf umfangreichen Video-Aktions-Paaren aus verschiedenen Domänen trainiert und unterstützt eine offene, aktionsbedingte Simulation mit kohärenten, langfristigen Dynamiken. Experimente zeigen, dass PAN eine starke Leistung in der aktionsbedingten Weltsimulation, der Langzeitprognose und dem simulativen Reasoning erzielt. Dies deutet darauf hin, dass Modelle, die Sprachmodelle und Diffusionsmodelle kombinieren, einen Weg zu allgemeineren Weltmodellen ebnen könnten, die eine prädiktive Simulation zukünftiger Weltzustände für Reasoning und Handeln ermöglichen.

Architektur von PAN

Die Architektur von PAN, basierend auf dem Generative Latent Prediction (GLP)-Ansatz, besteht aus drei Kernkomponenten:

- Vision Encoder: Dieser wandelt visuelle Beobachtungen in strukturierte latente Repräsentationen um.

- Autoregressives Weltmodell-Backbone: Basierend auf einem LLM (z.B. Qwen2.5-VL-7B-Instruct) entwickelt es den latenten Zustand der Welt unter dem Einfluss von Aktionen weiter.

- Video Diffusion Decoder: Dieser rekonstruiert beobachtbare Ergebnisse aus latenten Zuständen und erzeugt visuell detaillierte und zeitlich kohärente Videos.

Durch die Kombination dieser Komponenten kann PAN sowohl die Entwicklung latenter als auch beobachtbarer Welten in einem kohärenten generativen Prozess simulieren. Ein entscheidender Aspekt ist die Kausale Shift-Window Denoising Process Model (Causal Swin-DPM)-Methode im Videodiffusions-Decoder, die eine reibungslose Überlagerung von Videosegmenten und eine verbesserte Langzeitkohärenz ermöglicht, selbst bei unvollständigen Informationen über zukünftige Details.

Evaluierung von Weltmodellen

Die Evaluierung von Weltmodellen erfordert mehr als nur die Beurteilung der visuellen Qualität. PAN wird anhand von drei Dimensionen bewertet:

- Action Simulation Fidelity: Misst, wie genau das Modell sprachlich spezifizierte Aktionen und deren kausale Konsequenzen simuliert.

- Long-horizon Forecast: Bewertet die Fähigkeit des Modells, kohärente und qualitativ hochwertige Simulationen über längere Aktionssequenzen hinweg aufrechtzuerhalten.

- Simulative Reasoning and Planning: Untersucht, ob das Weltmodell als interner Simulator für die Entscheidungsfindung und Planung durch einen Agenten dienen kann.

Diese umfassende Evaluierung zielt darauf ab, die tatsächlichen Fähigkeiten von Weltmodellen zu erfassen und den Fortschritt in Richtung intelligenterer, handlungsfähigerer KI-Systeme zu messen.

Fazit

Die Entwicklung von Videogenerierungsmodellen hin zu echten Weltmodellen ist ein komplexes Unterfangen, das eine tiefgreifende Verschiebung in der Modellarchitektur, den Trainingsmethoden und den Bewertungskriterien erfordert. Die mechanistische Sichtweise, die in der besprochenen Studie vorgestellt wird, bietet einen Rahmen, um die aktuellen Fähigkeiten und zukünftigen Herausforderungen in diesem Bereich zu verstehen. Modelle wie PAN demonstrieren das Potenzial, durch die Integration von Sprach- und Diffusionsmodellen, signifikante Fortschritte zu erzielen. Der Übergang von der Generierung visueller Plausibilität zum Aufbau robuster, universeller Weltsimulatoren ist ein entscheidender Schritt auf dem Weg zu einer allgemeineren Künstlichen Intelligenz, die in der Lage ist, die Welt zu verstehen, vorherzusagen und mit ihr zu interagieren.

Bibliographie

- Wang, L., Chen, Z., Du, Y., Yan, D., Ge, W., Shen, G., Xu, X., Wu, L., Chen, M., Xu, T., Ren, P., Tao, X., Wan, P., & Chen, Y.-C. (2026). A Mechanistic View on Video Generation as World Models: State and Dynamics. arXiv.

- Kang, B., Yue, Y., Lu, R., Lin, Z., Zhao, Y., Wang, K., Huang, G., & Feng, J. (2024). How Far is Video Generation from World Model: A Physical Law Perspective. phyworld.github.io.

- Chen, T., Hu, X., Ding, Z., & Jin, C. (2025). Learning World Models for Interactive Video Generation. arXiv.

- Huang, S., Wu, J., Zhou, Q., Miao, S., & Long, M. (2025). Vid2World: Crafting Video Diffusion Models to Interactive World Models. arXiv.

- Li, D., Fang, Y., Chen, Y., Yang, S., Cao, S., Wong, J., Luo, M., Wang, X., Yin, H., Gonzalez, J. E., Stoica, I., Han, S., & Lu, Y. (2025). WorldModelBench: Judging Video Generation Models As World Models. arXiv.

- PAN Team, Institute of Foundation Models. (2025). PAN: A World Model for General, Interactable, and Long-Horizon World Simulation. arXiv.

- Zhang, J., Jiang, M., Dai, N., Lu, T., Uzunoglu, A., Zhang, S., Wei, Y., Wang, J., Patel, V. M., Liang, P. P., Khashabi, D., Peng, C., Chellappa, R., Shu, T., Yuille, A., Du, Y., & Chen, J. (2025). World-in-World: World Models in a Closed-Loop World. arXiv.

.svg)

.png)