EvoCUA Ein neuer Ansatz für agentische Computernutzung durch evolutionäres Lernen

KI sauber im Unternehmen integrieren: Der 5-Schritte-Plan

Von der ersten Idee bis zur voll integrierten KI-Lösung – strukturiert, sicher und mit messbarem Erfolg

Strategie & Zieldefinition

Wir analysieren Ihre Geschäftsprozesse und identifizieren konkrete Use Cases mit dem höchsten ROI-Potenzial.

✓ Messbare KPIs definiert

Daten & DSGVO-Compliance

Vollständige Datenschutz-Analyse und Implementierung sicherer Datenverarbeitungsprozesse nach EU-Standards.

✓ 100% DSGVO-konform

Technologie- & Tool-Auswahl

Maßgeschneiderte Auswahl der optimalen KI-Lösung – von Azure OpenAI bis zu Open-Source-Alternativen.

✓ Beste Lösung für Ihren Fall

Pilotprojekt & Integration

Schneller Proof of Concept mit nahtloser Integration in Ihre bestehende IT-Infrastruktur und Workflows.

✓ Ergebnisse in 4-6 Wochen

Skalierung & Team-Schulung

Unternehmensweiter Rollout mit umfassenden Schulungen für maximale Akzeptanz und Produktivität.

✓ Ihr Team wird KI-fit

Inhaltsverzeichnis

Optimieren Sie Prozesse, automatisieren Sie Workflows und fördern Sie Zusammenarbeit – alles an einem Ort.

Der schnelle Überblick

- EvoCUA ist ein neues Modell für agentische Computernutzung, das durch einen selbsttragenden evolutionären Zyklus aus Datengenerierung und Policy-Optimierung lernt.

- Es überwindet die Einschränkungen statischer Datensätze durch die Integration eines überprüfbaren Synthese-Engines und einer skalierbaren Interaktionsinfrastruktur.

- EvoCUA erreicht eine Erfolgsrate von 56,7 % auf dem OSWorld-Benchmark und übertrifft damit führende Open-Source- und einige Closed-Weights-Modelle.

- Das Framework setzt auf ein iteratives Lernverfahren, das Phasen des Supervised Cold-Start, Rejection Sampling Fine-Tuning und Reinforcement Learning kombiniert.

- Eine robuste, skalierbare Infrastruktur mit Tausenden von asynchronen Sandbox-Rollouts ermöglicht die Gewinnung umfangreicher Erfahrungen.

- Die Forschung hebt die Bedeutung von On-Policy-Daten und die asymmetrische Natur der Terminierungsdynamik in Langzeitaufgaben hervor.

Revolution in der Computerinteraktion: EvoCUA und die Evolution lernfähiger Agenten

Die Entwicklung nativer Computer-Nutzungsagenten (CUAs) stellt einen entscheidenden Fortschritt im Bereich der multimodalen KI dar. Diese Agenten zielen darauf ab, menschliche Computerinteraktionen zu emulieren, indem sie komplexe visuelle Kontexte wahrnehmen und Aufgaben über verschiedene Anwendungen hinweg ausführen. Bisherige Ansätze stießen jedoch an Grenzen, insbesondere bei der Skalierung mit statischen Datensätzen, die die komplexen kausalen Dynamiken von Langzeitaufgaben nicht ausreichend abbilden konnten. Ein Forschungsteam hat nun mit EvoCUA ein neues Modell vorgestellt, das diese Herausforderungen durch einen innovativen, evolutionären Lernansatz überwindet.

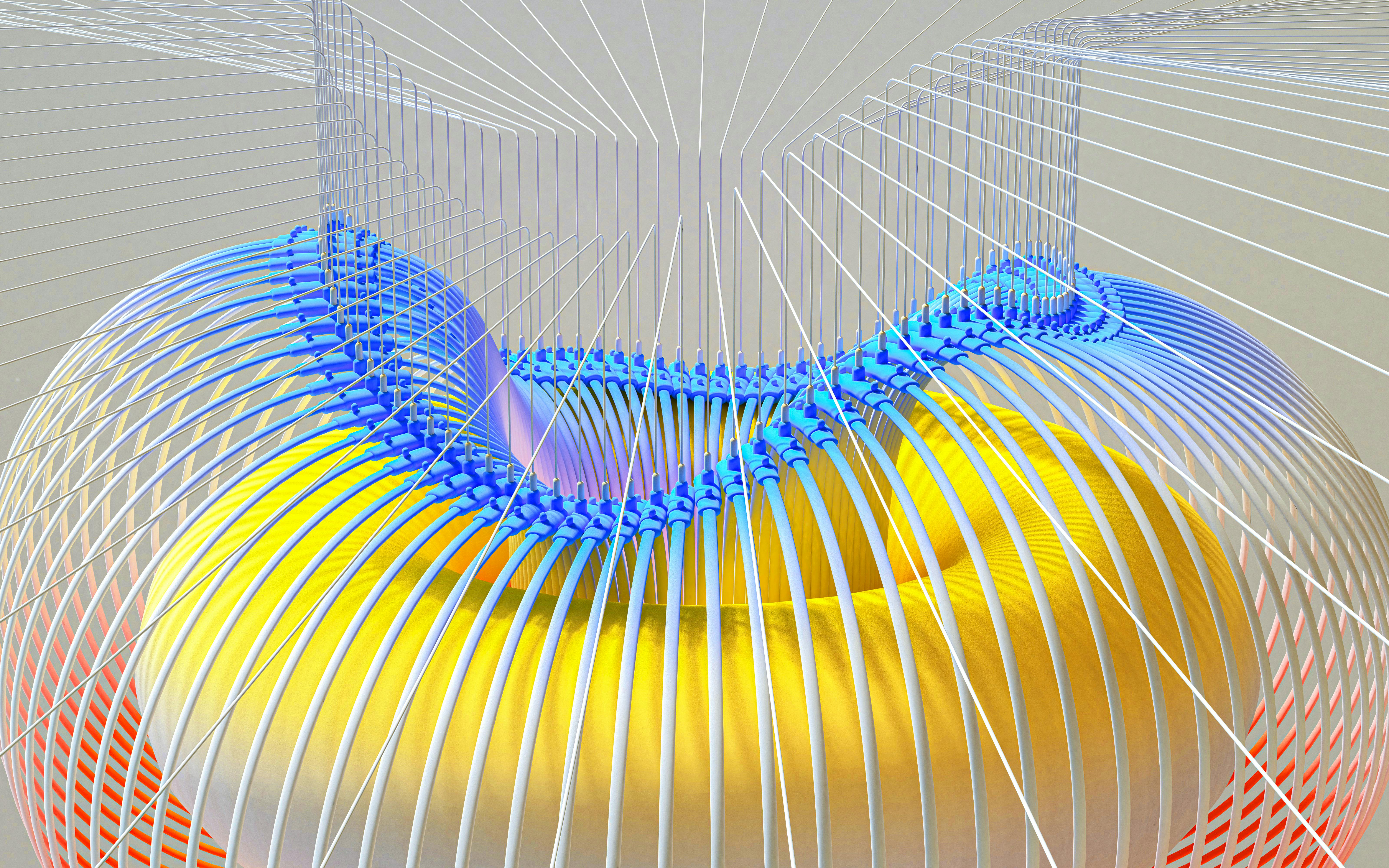

Die Kerninnovation von EvoCUA

Im Gegensatz zu traditionellen Methoden, die auf dem passiven Imitieren statischer Datensätze basieren, integriert EvoCUA die Datengenerierung und Policy-Optimierung in einen selbsttragenden Kreislauf. Dies ermöglicht es dem System, kontinuierlich aus Erfahrungen zu lernen und seine Fähigkeiten dynamisch zu entwickeln. Die Architektur von EvoCUA stützt sich auf drei zentrale Säulen:

- Einen überprüfbaren Synthese-Engine, der autonom vielfältige Aufgaben generiert und diese mit ausführbaren Validatoren koppelt. Dies adressiert das Problem der Datenknappheit und stellt sicher, dass generierte Aufgaben lösbar und nachvollziehbar sind.

- Eine skalierbare Interaktionsinfrastruktur, die Zehntausende asynchroner Sandbox-Rollouts orchestriert. Diese Infrastruktur ermöglicht die Erfassung umfangreicher Erfahrungen und liefert Echtzeit-Feedback, das für die On-Policy-Optimierung unerlässlich ist.

- Eine iterative evolutionäre Lernstrategie, die diese massiven Trajektorien effizient internalisiert. Dieser Mechanismus passt die Policy-Updates dynamisch an, indem er Erfolge verstärkt und Fehlschläge durch Fehleranalyse und Selbstkorrektur in wertvolle Lernerfahrungen umwandelt.

Herausforderungen und Lösungsansätze

Die Entwicklung von EvoCUA zielte darauf ab, drei Hauptprobleme zu lösen, die bei der Transformation von Rohinteraktionen in selbstverbessernde Lernschleifen auftreten:

- Überprüfbare Datensynthese: Die bloße Synthese von Textanfragen führt oft zu Halluzinationen. EvoCUA begegnet dem mit einem Synthese-Engine, der Aufgaben und dazugehörige Validatoren generiert, die strikt in lösbaren Zuständen verankert sind.

- Skalierbare Interaktionsinfrastruktur: Die Produktion von Erfahrungen in großem Maßstab erfordert ein einheitliches System. EvoCUA nutzt eine Hochleistungs-Infrastruktur, die massive Umgebungssimulationen mit Reinforcement Learning kombiniert.

- Effiziente Trainingsmethode: Angesichts des riesigen Interaktionsraums ist eine uneingeschränkte Exploration rechnerisch unerschwinglich. EvoCUA verwendet einen On-Policy-Ansatz, der menschliche Lernmuster nachahmt: Beherrschte Routinen werden konsolidiert, während der Fokus auf Grenzaufgaben liegt, bei denen der Agent zwischen Erfolg und Misserfolg schwankt.

Architektur des überprüfbaren Synthese-Engines

Der Synthese-Engine von EvoCUA ist in drei Module unterteilt, die eine kaskadierende Operation ermöglichen:

- Strukturierte Aufgabenraumerstellung: Um die Komplexität realer Computernutzung abzubilden, wird ein hierarchischer Domänen-Taxonomie genutzt. Atomare Fähigkeiten werden identifiziert und kombiniert, um komplexe Szenarien zu bilden, ergänzt durch die Injektion hybrider Ressourcen (z.B. parametrische Synthese für strukturierte Daten und nicht-parametrische Injektion von öffentlichen Internetdaten für visuelle Diversität).

- Agentische Dual-Stream-Synthese: Ein VLM fungiert als "Task Architect", der gleichzeitig Anweisungen in natürlicher Sprache und ausführbaren Evaluator-Code generiert. Ein Closed-Loop-Feedback-Mechanismus stellt die Ausführbarkeit sicher, indem der generierte Code in einer Sandbox-Umgebung getestet und bei Bedarf korrigiert wird.

- Strenge Qualitätssicherung: Synthetisierte Datenpaare werden durch ein rigides Protokoll gefiltert, um Fehlinterpretationen und Datenlecks zu eliminieren. Dies umfasst konsistenzbasierte Filterung und dreifache Dekontamination (semantisch, konfigurationsbezogen, evaluatorbezogen).

Skalierbare Interaktionsinfrastruktur

Die Infrastruktur von EvoCUA ist darauf ausgelegt, eine hohe Durchsatzrate und Skalierbarkeit zu gewährleisten. Sie basiert auf zwei Kernabstraktionen: Tools (unveränderliche Definitionen von Simulationsumgebungen) und Clustern (dynamische Skalierungseinheiten für die Laufzeitinstanziierung). Ein asynchroner Gateway-Dienst und ein verteilter Scheduler ermöglichen die Orchestrierung Zehntausender gleichzeitiger Sandbox-Instanzen. Die Umgebung selbst wird mittels Hybrid-Virtualisierung (QEMU-KVM in Docker-Containern) und deterministischer Umgebungs-Kalibrierung (Anpassungen auf Kernel- und User-Space-Ebene für Eingabedeterminismus, Rendering-Konsistenz und Laufzeitstabilität) bereitgestellt.

Evolutionäres Lernen aus Erfahrung

Das Lernparadigma von EvoCUA durchläuft drei progressive Phasen:

- Cold-Start: Eine überwachte Initialisierungsphase, die eine robuste Verhaltensbasis schafft. Hierbei werden einheitliche Aktions- und Gedankensräume definiert und hochwertige Trajektorien zur Etablierung von Verhaltensprädiktoren genutzt.

- Rejection Sampling Fine-Tuning (RFT): Konsolidiert erfolgreiche Ausführungen, indem nur qualitativ hochwertige Trajektorien für das Training verwendet werden. Ein dynamisches Budgeting passt die Explorationsressourcen an die aktuelle Kompetenz des Agenten an.

- Reinforcement Learning (RL): Lernt aus Fehlern und erweitert die Fähigkeitsgrenzen durch Online-Interaktion. Eine Step-Level Direct Preference Optimization (DPO) konzentriert sich auf kritische Verzweigungspunkte in Fehlertrajektorien, um gezielte Korrekturen vorzunehmen.

Bewertung und Ergebnisse

Empirische Evaluationen auf dem OSWorld-Benchmark zeigen, dass EvoCUA-32B eine Erfolgsrate von 56,7 % erreicht. Dies stellt einen neuen Open-Source-Spitzenwert dar, der das vorherige beste Open-Source-Modell (OpenCUA-72B mit 45,0 %) und sogar führende Closed-Weights-Modelle wie UI-TARS-2 (53,1 %) übertrifft. Bemerkenswert ist, dass EvoCUA-32B diese Leistung unter einer strengeren 50-Schritt-Beschränkung erreicht, während Baselines typischerweise 100 Schritte benötigen. Auch kleinere Modelle wie EvoCUA-8B zeigen eine beeindruckende Leistung (46,1 %), die mit größeren 72B-Modellen konkurriert.

Ablationsstudien bestätigen die inkrementellen Verbesserungen durch jeden Bestandteil des EvoCUA-Frameworks, von der vereinheitlichten Aktionsraumdefinition über den Cold-Start bis hin zu RFT und DPO. Die Generalisierbarkeit des Ansatzes wurde auch auf dem OpenCUA-72B-Modell nachgewiesen.

Zukünftige Perspektiven

Die Forschung identifiziert die Diskrepanz zwischen Training und Inferenz in trajektorienbasiertem Training als eine wichtige Herausforderung. Ein vorgeschlagener Ansatz, die Step-Level Policy Optimization (STEPO), zielt darauf ab, diese Diskrepanz zu überwinden, indem Vorteile gleichmäßig auf alle Schritte einer Trajektorie verteilt werden. Dies fördert effizientere Aufgabenlösungen und eine verbesserte Erkundung.

Die zukünftige Arbeit wird sich auf die systematische Erweiterung der Online-Reinforcement-Learning-Grenzen konzentrieren, um die verbleibende Lücke zu führenden Closed-Weights-Systemen und menschlicher Zuverlässigkeit weiter zu schließen. Die Erkenntnisse aus über einer Million Beschleunigerstunden zeigen, dass eine transparente Debugging-Infrastruktur und die Optimierung des Signal-Rausch-Verhältnisses von Erfolgs- und Fehlschlags-Trajektorien entscheidend sind.

Die Entwicklung von EvoCUA stellt einen bedeutenden Schritt in Richtung autonomer und intelligenter Computer-Nutzungsagenten dar, die durch kontinuierliches, erfahrungsbasiertes Lernen ihre Fähigkeiten stetig verbessern.

Bibliography: - Ahn, J., Verma, R., Lou, R., Liu, D., Zhang, R., & Yin, W. (2024). Large language models for mathematical reasoning: progresses and challenges. arXiv preprint arXiv:2402.00157. - Anthropic (2025). Introducing claude sonnet 4.5. Note: https://www.anthropic.com/news/claude-sonnet-4-5 Accessed: 2025-10-31. - Bai, S., Cai, Y., Chen, R., Chen, K., Chen, X., Cheng, Z., Deng, L., Ding, W., Gao, C., Ge, C., Ge, W., Guo, Z., Huang, Q., Huang, J., Huang, F., Hui, B., Jiang, S., Li, Z., Li, M., Li, M., Li, K., Lin, Z., Lin, J., Liu, X., Liu, J., Liu, C., Liu, Y., Liu, D., Liu, S., Lu, D., Luo, R., Lv, C., Men, R., Meng, L., Ren, X., Ren, X., Song, S., Sun, Y., Tang, J., Tu, J., Wan, J., Wang, P., Wang, P., Wang, Q., Wang, Y., Xie, T., Xu, Y., Xu, H., Xu, J., Yang, Z., Yang, M., Yang, J., Yang, A., Yu, B., Zhang, F., Zhang, H., Zhang, X., Zheng, B., Zhong, H., Zhou, J., Zhou, F., Zhou, J., Zhu, Y., & Zhu, K. (2025a). Qwen3-vl technical report. arXiv preprint arXiv:2511.21631. - Bai, S., Chen, K., Liu, X., Wang, J., Ge, W., Song, S., Dang, K., Wang, P., Wang, S., Tang, J., Zhong, H., Zhu, Y., Yang, M., Li, Z., Wan, J., Wang, P., Ding, W., Fu, Z., Xu, Y., Ye, J., Zhang, X., Xie, T., Cheng, Z., Zhang, H., Yang, Z., Xu, H., & Lin, J. (2025b). Qwen2.5-vl technical report. arXiv preprint arXiv:2502.13923. - ByteDance Seed Team (2025). Seed 1.8. Note: https://github.com/ByteDance-Seed/Seed-1.8/ GitHub repository. - Chen, L., Li, J., Dong, X., Zhang, P., Zang, Y., Chen, Z., Duan, H., Wang, J., Qiao, Y., Lin, D., & Zhao, F. (2024). Are we on the right way for evaluating large vision-language models?. External Links:2403.20330, [Link]. - Feng, L., Xue, Z., Liu, T., & An, B. (2025). Group-in-group policy optimization for llm agent training. arXiv preprint arXiv:2505.10978. - Ge, T., Chan, X., Wang, X., Yu, D., Mi, H., & Yu, D. (2024). Scaling synthetic data creation with 1,000,000,000 personas. arXiv preprint arXiv:2406.20094. - Gou, B., Wang, R., Zheng, B., Xie, Y., Chang, C., Shu, Y., Sun, H., & Su, Y. (2024). Navigating the digital world as humans do: universal visual grounding for gui agents. arXiv preprint arXiv:2410.05243. - Guo, D., Yang, D., Zhang, H., Song, J., Zhang, R., Xu, R., Zhu, Q., Ma, S., Wang, P., Bi, X., et al. (2025). Deepseek-r1: incentivizing reasoning capability in llms via reinforcement learning. arXiv preprint arXiv:2501.12948. - Kaelbling, L. P., Littman, M. L., & Cassandra, A. R. (1998). Planning and acting in partially observable stochastic domains. Artificial intelligence, 101(1-2), 99–134. - Lai, X., Tian, Z., Chen, Y., Yang, S., Peng, X., & Jia, J. (2024). Step-dpo: step-wise preference optimization for long-chain reasoning of llms. arXiv preprint arXiv:2406.18629. - Li, K., Ziyang, M., Lin, H., Luo, Z., Tian, Y., Ma, J., Huang, Z., & Chua, T. (2025). ScreenSpot-pro: GUI grounding for professional high-resolution computer use. In Workshop on Reasoning and Planning for Large Language Models, External Links: [Link]. - Lin, K. Q., Li, L., Gao, D., Yang, Z., Wu, S., Bai, Z., Lei, S. W., Wang, L., & Shou, M. Z. (2025). Showui: one vision-language-action model for gui visual agent. In Proceedings of the Computer Vision and Pattern Recognition Conference, 19498–19508. - Liu, Y., Li, Z., Huang, M., Yang, B., Yu, W., Li, C., Yin, X., Liu, C., Jin, L., & Bai, X. (2024). OCRBench: on the hidden mystery of ocr in large multimodal models. Science China Information Sciences, 67(12). External Links: ISSN 1869-1919, [Link], [Document]. - Lu, P., Bansal, H., Xia, T., Liu, J., Li, C., Hajishirzi, H., Cheng, H., Chang, K., Galley, M., & Gao, J. (2024). MathVista: evaluating mathematical reasoning of foundation models in visual contexts. External Links: 2310.02255, [Link]. - OpenAI (2025). Computer-using agent (cua). Note: https://openai.com/index/computer-using-agent/ Accessed: 2025-10-01. - Qin, Y., Ye, Y., Fang, J., Wang, H., Liang, S., Tian, S., Zhang, J., Li, J., Li, Y., Huang, S., et al. (2025). Ui-tars: pioneering automated gui interaction with native agents. arXiv preprint arXiv:2501.12326. - Schulman, J., Wolski, F., Dhariwal, P., Radford, A., & Klimov, O. (2017). Proximal policy optimization algorithms. arXiv preprint arXiv:1707.06347. - Shao, Z., Wang, P., Zhu, Q., Xu, R., Song, J., Bi, X., Zhang, H., Zhang, M., Li, Y., Wu, Y., et al. (2024). Deepseekmath: pushing the limits of mathematical reasoning in open language models. arXiv preprint arXiv:2402.03300. - Wang, H., Zou, H., Song, H., Feng, J., Fang, J., Lu, J., Liu, L., Luo, Q., Liang, S., Huang, S., et al. (2025a). Ui-tars-2 technical report: advancing gui agent with multi-turn reinforcement learning. arXiv preprint arXiv:2509.02544. - Wang, X., Wang, B., Lu, D., Yang, J., Xie, T., Deng, J., Guo, X., Xu, Y., Wu, C. H., et al. (2025b). Opencua: open foundations for computer-use agents. arXiv preprint arXiv:2508.09123. - Wu, Z., Wu, Z., Xu, F., Wang, Y., Sun, Q., Jia, C., Cheng, K., Ding, Z., Chen, L., Liang, P. P., et al. (2024). Os-atlas: a foundation action model for generalist gui agents. arXiv preprint arXiv:2410.23218. - Xie, T., Deng, J., Li, X., Yang, J., Wu, H., Chen, J., Hu, W., Wang, X., Xu, Y., Wang, Z., Xu, Y., Wang, J., Sahoo, D., Yu, T., & Xiong, C. (2025). Scaling computer-use grounding via user interface decomposition and synthesis. External Links: 2505.13227, [Link]. - Xie, T., Zhang, D., Chen, J., Li, X., Zhao, S., Cao, R., Hua, T. J., Cheng, Z., Shin, D., Lei, F., et al. (2024). Osworld: benchmarking multimodal agents for open-ended tasks in real computer environments. Advances in Neural Information Processing Systems, 37, 52040–52094. - Xu, Y., Wang, Z., Wang, J., Lu, D., Xie, T., Saha, A., Sahoo, D., Yu, T., & Xiong, C. (2024). Aguvis: unified pure vision agents for autonomous gui interaction. arXiv preprint arXiv:2412.04454. - Yan, H., Wang, J., Huang, X., Shen, Y., Meng, Z., Fan, Z., Tan, K., Gao, J., Shi, L., Yang, M., et al. (2025). Step-gui technical report. arXiv preprint arXiv:2512.15431. - Yang, Y., Yang, Z., Dou, Z., Nguyen, A., You, K., Attia, O., Szot, A., Feng, M., Ramrakhya, R., Toshev, A., et al. (2025). UltraCUA: a foundation model for computer use agents with hybrid action. arXiv preprint arXiv:2510.17790. - Yao, S., Zhao, J., Yu, D., Du, N., Shafran, I., Narasimhan, K. R., & Cao, Y. (2022). React: synergizing reasoning and acting in language models. In The eleventh international conference on learning representations. - Yue, X., Ni, Y., Zhang, K., Zheng, T., Liu, R., Zhang, G., Stevens, S., Jiang, D., Ren, W., Sun, Y., Wei, C., Yu, B., Yuan, R., Sun, R., Yin, M., Zheng, B., Yang, Z., Liu, Y., Huang, W., Sun, H., Su, Y., & Chen, W. (2024). MMMU: a massive multi-discipline multimodal understanding and reasoning benchmark for expert agi. External Links: 2311.16502, [Link]. - Yue, X., Zheng, T., Ni, Y., Wang, Y., Zhang, K., Tong, S., Sun, Y., Yu, B., Zhang, G., Sun, H., Su, Y., Chen, W., & Neubig, G. (2025). MMMU-pro: a more robust multi-discipline multimodal understanding benchmark. External Links: 2409.02813, [Link]. - Zhang, K., Chen, X., Liu, B., Xue, T., Liao, Z., Liu, Z., Wang, X., Ning, Y., Chen, Z., Fu, X., et al. (2025). Agent learning via early experience. arXiv preprint arXiv:2510.08558. - Xue, T., Peng, C., Huang, M., Guo, L., Han, T., Wang, H., Wang, J., Zhang, X., Yang, X., Zhao, D., Ding, J., Ma, X., Xie, Y., Pei, P., Cai, X., & Qiu, X. (2026). EvoCUA: Evolving Computer Use Agents via Learning from Scalable Synthetic Experience. arXiv preprint arXiv:2601.15876.

.svg)

.png)