Effiziente Videogenerierung durch Transition Matching Distillation

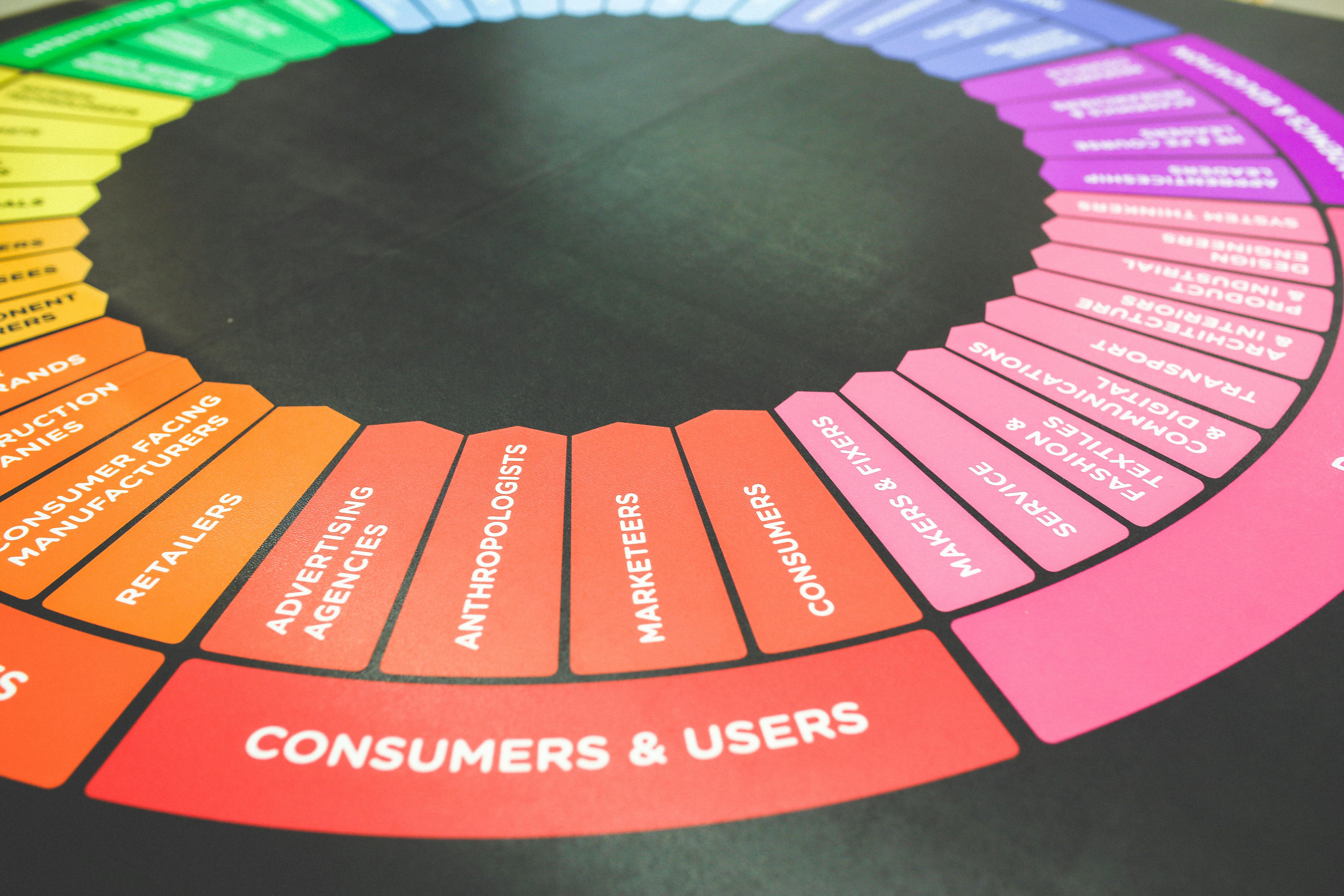

KI sauber im Unternehmen integrieren: Der 5-Schritte-Plan

Von der ersten Idee bis zur voll integrierten KI-Lösung – strukturiert, sicher und mit messbarem Erfolg

Strategie & Zieldefinition

Wir analysieren Ihre Geschäftsprozesse und identifizieren konkrete Use Cases mit dem höchsten ROI-Potenzial.

✓ Messbare KPIs definiert

Daten & DSGVO-Compliance

Vollständige Datenschutz-Analyse und Implementierung sicherer Datenverarbeitungsprozesse nach EU-Standards.

✓ 100% DSGVO-konform

Technologie- & Tool-Auswahl

Maßgeschneiderte Auswahl der optimalen KI-Lösung – von Azure OpenAI bis zu Open-Source-Alternativen.

✓ Beste Lösung für Ihren Fall

Pilotprojekt & Integration

Schneller Proof of Concept mit nahtloser Integration in Ihre bestehende IT-Infrastruktur und Workflows.

✓ Ergebnisse in 4-6 Wochen

Skalierung & Team-Schulung

Unternehmensweiter Rollout mit umfassenden Schulungen für maximale Akzeptanz und Produktivität.

✓ Ihr Team wird KI-fit

Inhaltsverzeichnis

Optimieren Sie Prozesse, automatisieren Sie Workflows und fördern Sie Zusammenarbeit – alles an einem Ort.

Das Wichtigste in Kürze

- Die "Transition Matching Distillation" (TMD) ist ein neues Framework, das die Generierung von Videos durch große Diffusionsmodelle erheblich beschleunigt.

- TMD überführt ineffiziente, mehrstufige Sampling-Prozesse in effiziente, wenige Schritte umfassende Generatoren.

- Das Framework verwendet eine entkoppelte Architektur mit einem Haupt-Backbone für semantische Merkmale und einem Flow-Head für die iterative Verfeinerung.

- Ein zweistufiges Trainingsverfahren, bestehend aus Transition Matching Pretraining und Distribution Matching Distillation, ist entscheidend für die Leistungsfähigkeit von TMD.

- TMD zeigt eine überlegene Balance zwischen Generierungsgeschwindigkeit und visueller Qualität im Vergleich zu bestehenden Methoden, insbesondere bei geringen Inferenzschritten.

- Anwendungsbereiche umfassen die Echtzeit-Videoproduktion, dynamische Weltmodellierung für KI-Agenten und die skalierbare Bereitstellung von Videogenerierungsmodellen.

Die Generierung hochwertiger Videos mittels künstlicher Intelligenz hat in den letzten Jahren beeindruckende Fortschritte gemacht. Modelle wie Sora, Veo oder HunyuanVideo können aus Textbeschreibungen überzeugende und kohärente Videosequenzen erstellen. Trotz dieser Erfolge sehen sich Anwender und Entwickler mit einer grundlegenden Herausforderung konfrontiert: der erheblichen Rechenintensität und Zeit, die für das Sampling dieser Modelle erforderlich ist. Standard-Diffusionsmodelle benötigen oft Hunderte von iterativen Denoising-Schritten, um aus Rauschen ein fertiges Video zu erzeugen. Dies führt zu einer hohen Inferenzlatenz, welche den Einsatz in Echtzeitanwendungen, wie interaktiver Videobearbeitung oder dynamischer Weltmodellierung für KI-Agenten, bisher stark einschränkt.

Die Herausforderung der Effizienz in der Videogenerierung

Die inhärente Natur von Diffusionsmodellen, die schrittweise Rauschen entfernen, bedingt, dass jeder Schritt einen vollständigen Durchlauf durch das neuronale Netzwerk erfordert. Dies kumuliert zu einer beträchtlichen Rechenlast. Um dieses Effizienzproblem zu lösen, wurden Strategien der Diffusionsdestillation entwickelt. Das Ziel dabei ist es, das Wissen eines "Lehrer"-Modells, das viele Schritte benötigt, in ein "Student"-Modell zu komprimieren, das eine vergleichbare Qualität mit deutlich weniger Schritten erreichen kann. Die Übertragung dieser Techniken auf Videos stellt jedoch besondere Anforderungen dar, da die hohe raumzeitliche Dimensionalität und die komplexen Abhängigkeiten zwischen den Frames erhalten bleiben müssen.

"Transition Matching Distillation" (TMD): Ein neuer Ansatz

Ein vielversprechender neuer Ansatz zur Beschleunigung der Videogenerierung ist die "Transition Matching Distillation" (TMD). Dieses Framework, entwickelt von Forschenden unter anderem von NVIDIA und NYU, zielt darauf ab, große Video-Diffusionsmodelle in effiziente Generatoren mit wenigen Schritten zu überführen. Die Kernidee von TMD besteht darin, die mehrstufige Denoising-Trajektorie eines Diffusionsmodells mit einem probabilistischen Übergangsprozess zu matchen, der nur wenige Schritte umfasst. Jeder dieser Übergänge wird dabei als ein leichter, konditionaler Fluss modelliert.

Entkoppelte Architektur für Effizienz

TMD führt eine entkoppelte Architektur für das Student-Modell ein, die das Lernen semantischer Repräsentationen von der feinkörnigen Verfeinerung trennt. Diese Architektur besteht aus zwei Hauptkomponenten:

- Haupt-Backbone: Dieser Teil umfasst die meisten frühen Schichten des Lehrer-Modells. Seine Aufgabe ist es, auf jeder äußeren Übergangsstufe hochrangige semantische Repräsentationen zu extrahieren.

- Flow-Head: Dieser leichte Bestandteil, der aus den letzten Schichten besteht, führt mehrere innere Flow-Updates durch, um visuelle Details zu verfeinern. Er nutzt dabei die vom Haupt-Backbone bereitgestellten Repräsentationen.

Dieses Design ermöglicht es, Rechenressourcen für das semantische Verständnis zu teilen, während spezialisierte Berechnungen der iterativen Verfeinerung innerhalb jedes größeren Denoising-Schritts gewidmet werden.

Zweistufige Trainingsstrategie

Die TMD-Methode nutzt eine sorgfältig konzipierte zweistufige Trainingsstrategie, um den Komplexitäten der Videodestillation gerecht zu werden:

- Stufe 1: Transition Matching Pretraining (TM-MF): In dieser Phase wird der Flow-Head so angepasst, dass er ein effektives iteratives Verfeinerungsmodul wird. Dies geschieht unter Verwendung einer modifizierten MeanFlow-Zielsetzung. Der Flow-Head lernt, basierend auf Merkmalen des Haupt-Backbones, eine konditionale Flussabbildung durchzuführen. Eine zentrale Rolle spielt dabei die "Difference Transition Matching" (DTM)-Formulierung.

- Stufe 2: Distribution Matching Distillation: Die zweite Stufe beinhaltet die eigentliche Destillation unter Verwendung einer verbesserten Version von DMD2 (DMD2-v), die speziell für Videos adaptiert wurde. Zu den wesentlichen Verbesserungen gehören die Verwendung eines Conv3D-GAN-Diskriminators zur Erfassung raumzeitlicher Merkmale, eine selektive Knowledge Distillation (KD)-Aufwärmphase (nur für einstufige Destillation) und eine Timestep-Shifting-Funktion, die Modenkollaps verhindert und die Leistung verbessert. Während dieser Phase wird der innere Fluss (die Verfeinerungsschritte des Flow-Heads) abgerollt, wodurch Gradienten durch alle Verfeinerungsschritte zurückpropagiert werden können, was die Lücke zwischen Training und Inferenz effektiv schließt.

Effektive Leistungsbewertung

Um eine faire Vergleichbarkeit zu gewährleisten, führt TMD die Metrik "Effective Number of Function Evaluations" (NFE) ein. Diese berücksichtigt die zusätzliche Berechnung innerhalb des Flow-Heads und dessen leichte Natur. Die Formel für die effektive NFE lautet:

Effective NFE = M × (1 + (N-1) * H/L)

Wobei M die Anzahl der äußeren Schritte, N die Anzahl der inneren Flow-Schritte, H die Anzahl der Flow-Head-Blöcke und L die Gesamtanzahl der Lehrer-Blöcke ist.

Experimentelle Ergebnisse und qualitative Verbesserungen

TMD wurde an modernen Wan2.1-Modellen (1.3B und 14B Parameter) unter Verwendung des VBench-Benchmarks und menschlicher Präferenzstudien evaluiert. Die Ergebnisse zeigen, dass TMD im Vergleich zu bestehenden destillierten Modellen bei vergleichbaren Inferenzkosten eine überlegene visuelle Wiedergabetreue und Prompthaltigkeit bietet. Insbesondere bei ein- oder zweistufiger Generierung konnte TMD signifikante Verbesserungen erzielen, sowohl in quantitativen VBench-Scores als auch in der menschlichen Wahrnehmung der Videoqualität und der Übereinstimmung mit den Text-Prompts.

Ablationsstudien und Designvalidierung

Umfassende Ablationsstudien bestätigten die Wirksamkeit der einzelnen Designentscheidungen von TMD:

- Das Abrollen des Flow-Heads während des Trainings führte zu einer schnelleren Konvergenz und einer deutlich verbesserten Leistung.

- Das MeanFlow-Pretraining-Ziel übertraf konsistent das herkömmliche Flow-Matching für die Initialisierung.

- Conv3D-Diskriminatoren erwiesen sich als essenziell für Videos, während Timestep-Shifting einen Modenkollaps verhinderte.

- Die Beschränkung auf einstufige Verfeinerung (N=1) führte zu merklich geringerer Qualität und mehr Artefakten.

Bedeutung und zukünftige Auswirkungen

TMD stellt einen wichtigen Fortschritt dar, um hochwertige Videogenerierung für Echtzeitanwendungen praktikabel zu machen. Durch die Erzielung einer nahezu einstufigen Generierung bei gleichzeitiger Beibehaltung einer Qualität, die mit viel langsameren Methoden vergleichbar ist, ermöglicht TMD:

- Echtzeit-Interaktion: Für Content-Ersteller und Künstler wird die sofortige Videoproduktion realisierbar.

- Dynamische Weltmodellierung: KI-Agenten und Robotik-Anwendungen profitieren von schnelleren und realistischeren Simulationen.

- Reaktionsschnelle Videobearbeitung: Tools mit sofortigem Feedback werden möglich.

- Skalierbare Bereitstellung: Videogenerierungsmodelle können in ressourcenbeschränkten Umgebungen effizient eingesetzt werden.

Die entkoppelte Architektur und die zweistufige Trainingsstrategie von TMD könnten als Vorlage für die Destillation anderer großer generativer Modelle dienen. Zukünftige Arbeiten könnten die Vereinheitlichung der Trainingspipelines und die Integration mit systemweiten Optimierungen wie Feature-Caching oder effizienten Aufmerksamkeitsmechanismen erforschen, um eine noch größere Beschleunigung zu erreichen.

Literaturverzeichnis

- Nie, W. et al. (2026). Transition Matching Distillation for Fast Video Generation. arXiv. - Emergent Mind. (2026). Transition Matching Distillation (TMD). Emergent Mind. - alphaXiv. (2026). Transition Matching Distillation for Fast Video Generation. alphaXiv. - Yin, T. et al. (2025). From Slow Bidirectional to Fast Autoregressive Video Diffusion Models. CVPR 2025. - TheMoonlight.io. (2026). [Literature Review] Transition Matching Distillation for Fast Video Generation. TheMoonlight.io. - Shaul, N. et al. (2025). Transition matching: Scalable and flexible generative modeling. arXiv. - Yin, T. et al. (2024). Improved distribution matching distillation for fast image synthesis. NeurIPS. - Geng, Z. et al. (2025). Mean flows for one-step generative modeling. arXiv. - Zheng, K. et al. (2025). Large scale diffusion distillation via score-regularized continuous-time consistency. arXiv.

.svg)

.png)